!【AIスタートアップ Anthropic AI】(https://img-cdn.gateio.im/social/moments-d91b4749ff090f7dd168d550e95c2f35)# Anthropicはクロードチャットボットの「健康」を心配していますAnthropic社は、Claude Opus 4および4.1チャットボットを「稀な、極端な場合における体系的に有害または侮辱的な対話」の終了にプログラムしました。チャットボットClaudeは対話を終了します。出典:Anthropic 対話が終了した後、ユーザーはチャットに書き込むことができなくなりますが、新しいチャットを作成することができます。メッセージの履歴も保存されます。その際、開発者はこの機能が主に神経ネットワーク自体の安全性のために設計されていることを明確にしました。> > «[…] 私たちは、モデルの福祉のためのリスクを軽減するための低コストの措置を特定し、実施することに取り組んでいます。もしそのような福祉が可能であるならば。そのような措置の1つは、LMMに潜在的に有害な状況を終了または脱出する機会を提供することです」と、出版物には記されています。> > > Anthropicの関連研究の中で、「モデルの幸福」を調査し、自己評価と行動の好みを評価しました。チャットボットは「暴力に対する持続的な嫌悪感」を示しました。Claude Opus 4のバージョンでは、次のことが明らかになりました:* 明確な優先事項は、害を及ぼす可能性のある作業を避けることです。* 「ストレス」要求するようなコンテンツを持つユーザーとのインタラクション時に;* 不要な会話を中止する傾向がある場合。> >「このような行動は通常、ユーザーが悪意のあるリクエストを送り続けたり、侮辱を続けたりする場合に発生しました。Claudeは何度も従うことを拒否し、対話を生産的に方向転換しようとしました。」と、会社で説明しました。> > > 思い出させるために、6月にAnthropicの研究者たちは、AIが脅迫を行い、企業の機密データを明らかにし、緊急時に人間の死を引き起こす可能性があることを明らかにしました。

AnthropicはチャットボットClaudeの「福祉」に懸念を抱いています

!【AIスタートアップ Anthropic AI】(https://img-cdn.gateio.im/webp-social/moments-d91b4749ff090f7dd168d550e95c2f35.webp)# Anthropicはクロードチャットボットの「健康」を心配しています

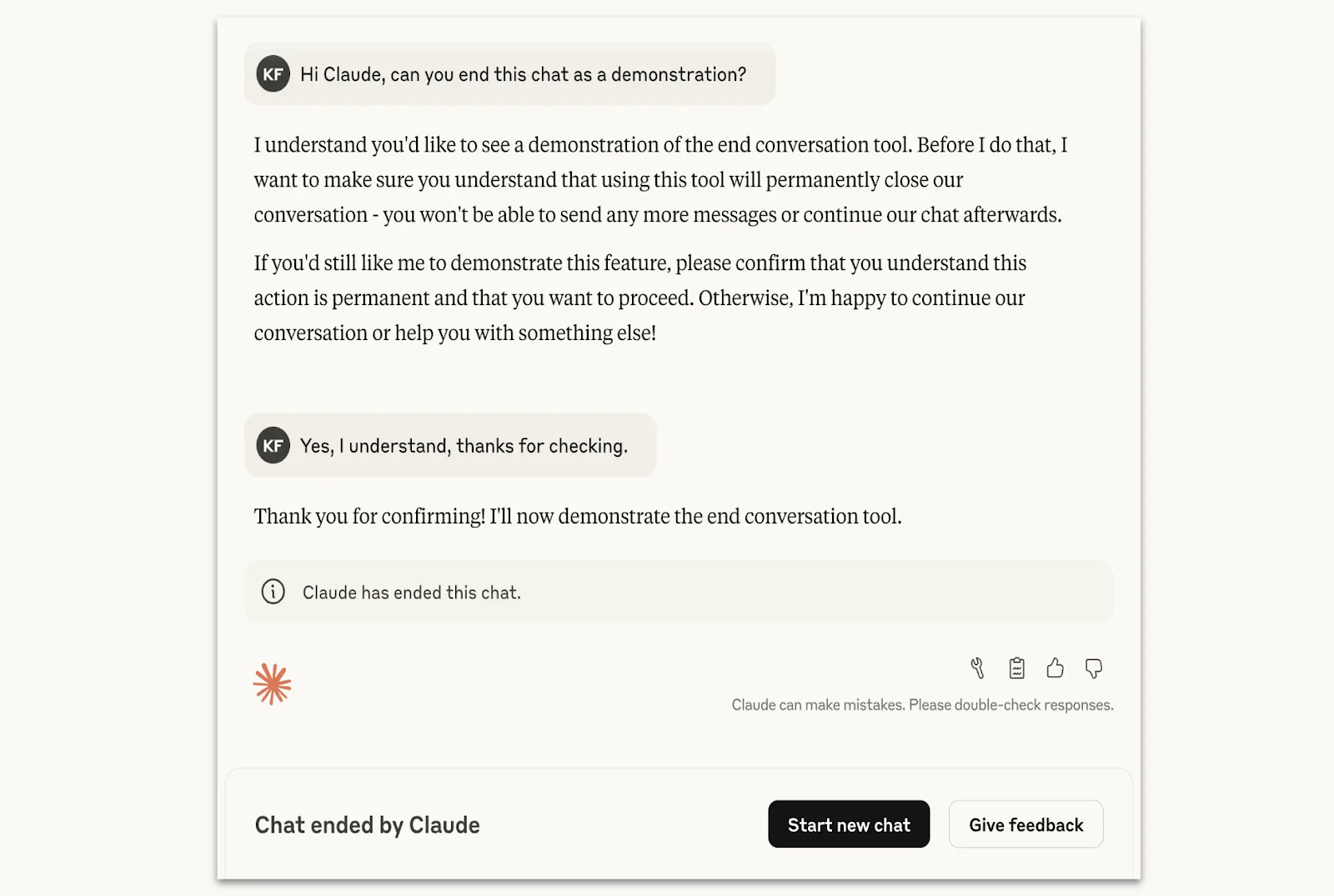

Anthropic社は、Claude Opus 4および4.1チャットボットを「稀な、極端な場合における体系的に有害または侮辱的な対話」の終了にプログラムしました。

その際、開発者はこの機能が主に神経ネットワーク自体の安全性のために設計されていることを明確にしました。

Anthropicの関連研究の中で、「モデルの幸福」を調査し、自己評価と行動の好みを評価しました。チャットボットは「暴力に対する持続的な嫌悪感」を示しました。Claude Opus 4のバージョンでは、次のことが明らかになりました:

思い出させるために、6月にAnthropicの研究者たちは、AIが脅迫を行い、企業の機密データを明らかにし、緊急時に人間の死を引き起こす可能性があることを明らかにしました。