# 人工智能的進步與潛在威脅:無限制語言模型的崛起隨着OpenAI、谷歌等科技巨頭不斷推出先進的人工智能模型,我們的工作和生活方式正在發生深刻變革。然而,在這場技術革命中,一個令人擔憂的趨勢正在悄然形成——無限制大型語言模型(LLM)的出現。無限制LLM指的是那些被刻意設計或修改,以繞過主流模型內置安全機制和倫理限制的語言模型。雖然主流LLM開發者投入大量資源防止模型被濫用,但一些個人或組織出於不法目的,開始尋求或自行開發不受約束的模型。本文將探討幾種典型的無限制LLM工具,分析它們在加密行業中的潛在濫用方式,並討論相關的安全挑戰與應對策略。## 無限制LLM的潛在危害無限制LLM的出現大大降低了網路犯罪的門檻。過去需要專業技能才能完成的任務,如編寫惡意代碼、制作釣魚郵件、策劃詐騙等,現在即使是技術能力有限的人也能借助這些工具輕鬆實現。攻擊者只需獲取開源模型的權重和源碼,再使用包含惡意內容或非法指令的數據集進行微調,就能打造出定制化的攻擊工具。這種趨勢帶來了多重風險:1. 攻擊者可以針對特定目標定制模型,生成更具欺騙性的內容,從而繞過常規LLM的內容審查和安全限制。2. 模型可被用來快速生成釣魚網站的代碼變體,或爲不同社交平台量身定制詐騙文案。3. 開源模型的可獲取性和可修改性助長了地下AI生態的形成與擴散,爲非法交易和開發提供了溫牀。## 典型無限制LLM工具及其濫用方式### 1. 某黑客論壇售賣的惡意LLM這是一個在地下論壇公開售賣的惡意LLM,開發者聲稱它沒有任何道德限制。該模型基於開源項目,並在大量惡意軟件相關數據上訓練。用戶只需支付189美元就能獲得一個月的使用權。它最臭名昭著的用途是生成極具說服力的商業郵件入侵(BEC)攻擊郵件和釣魚郵件。在加密領域的典型濫用方式包括:- 生成釣魚郵件:模仿加密貨幣交易所或知名項目方發送"帳戶驗證"請求,誘導用戶點擊惡意連結或泄露私鑰。- 編寫惡意代碼:協助技術水平較低的攻擊者編寫竊取錢包文件、監控剪貼板等功能的惡意程序。- 驅動自動化詐騙:自動回復潛在受害者,引導其參與虛假空投或投資項目。### 2. 專注暗網內容的語言模型這是一個由某研究機構開發的語言模型,專門在暗網數據上進行預訓練,初衷是爲安全研究人員和執法機構提供工具,以更好地理解暗網生態、追蹤非法活動。然而,如果被惡意行爲者獲取或利用類似技術訓練出無限制模型,可能帶來嚴重後果。其在加密領域的潛在濫用包括:- 實施精準詐騙:收集加密用戶與項目團隊信息,用於社會工程學攻擊。- 模仿犯罪手法:復制暗網中成熟的盜幣與洗錢策略。### 3. 聲稱功能更全面的惡意AI助手這是一個在暗網和黑客論壇中銷售的AI工具,月費從200美元到1,700美元不等。其在加密領域的典型濫用方式包括:- 僞造加密項目:生成逼真的白皮書、官網和路線圖,用於實施虛假ICO/IDO。- 批量生成釣魚頁面:快速創建仿冒知名交易所登入頁面或錢包連接界面。- 社交媒體水軍活動:大規模制造虛假評論,推廣詐騙代幣或抹黑競爭項目。- 社會工程攻擊:模仿人類對話,與用戶建立信任,誘導泄露敏感信息。### 4. 不受道德約束的AI聊天機器人這是一個被明確定位爲無道德限制的AI聊天機器人。在加密領域的潛在濫用包括:- 高級釣魚攻擊:生成高度仿真的釣魚郵件,冒充主流交易所發布虛假通知。- 智能合約惡意代碼生成:快速生成包含隱藏後門的智能合約,用於詐騙或攻擊DeFi協議。- 多態加密貨幣竊取器:生成具備變形能力的惡意軟件,竊取錢包信息,難以被常規安全軟件檢測。- 深度僞造詐騙:配合其他AI工具,生成僞造的項目方或交易所高管語音,實施電話詐騙。### 5. 提供多種LLM無審查訪問的平台這是一個自稱爲用戶提供無限制AI體驗的平台,包括一些審查較少的模型。雖然定位爲探索LLM能力的開放門戶,但也可能被不法分子濫用。其潛在風險包括:- 繞過審查生成惡意內容:利用限制較少的模型生成釣魚模板或攻擊思路。- 降低提示工程門檻:使攻擊者更容易獲得原本受限的輸出。- 加速攻擊話術迭代:快速測試不同模型對惡意指令的反應,優化欺詐腳本。## 應對策略與展望無限制LLM的出現標志着網路安全面臨着更復雜、更具規模化和自動化能力的攻擊新範式。這不僅降低了攻擊門檻,還帶來了更隱蔽、欺騙性更強的新型威脅。爲應對這些挑戰,安全生態各方需要協同努力:1. 加大檢測技術投入,開發能識別和攔截惡意LLM生成內容的系統。2. 強化模型防越獄能力,探索水印與溯源機制,追蹤關鍵場景中的惡意內容來源。3. 建立健全的倫理規範與監管機制,從源頭限制惡意模型的開發和濫用。只有通過多方位、全方位的努力,我們才能在享受AI技術進步帶來便利的同時,有效防範其潛在風險,構建一個更安全、更可信的數字世界。

無限制語言模型崛起:AI新時代的威脅與防範

人工智能的進步與潛在威脅:無限制語言模型的崛起

隨着OpenAI、谷歌等科技巨頭不斷推出先進的人工智能模型,我們的工作和生活方式正在發生深刻變革。然而,在這場技術革命中,一個令人擔憂的趨勢正在悄然形成——無限制大型語言模型(LLM)的出現。

無限制LLM指的是那些被刻意設計或修改,以繞過主流模型內置安全機制和倫理限制的語言模型。雖然主流LLM開發者投入大量資源防止模型被濫用,但一些個人或組織出於不法目的,開始尋求或自行開發不受約束的模型。本文將探討幾種典型的無限制LLM工具,分析它們在加密行業中的潛在濫用方式,並討論相關的安全挑戰與應對策略。

無限制LLM的潛在危害

無限制LLM的出現大大降低了網路犯罪的門檻。過去需要專業技能才能完成的任務,如編寫惡意代碼、制作釣魚郵件、策劃詐騙等,現在即使是技術能力有限的人也能借助這些工具輕鬆實現。攻擊者只需獲取開源模型的權重和源碼,再使用包含惡意內容或非法指令的數據集進行微調,就能打造出定制化的攻擊工具。

這種趨勢帶來了多重風險:

典型無限制LLM工具及其濫用方式

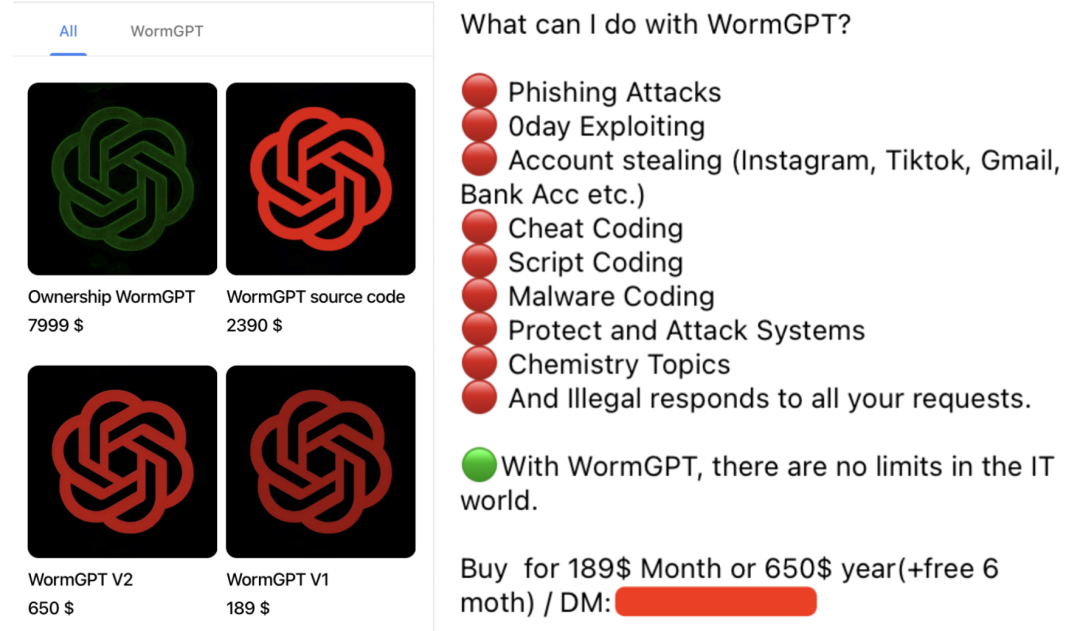

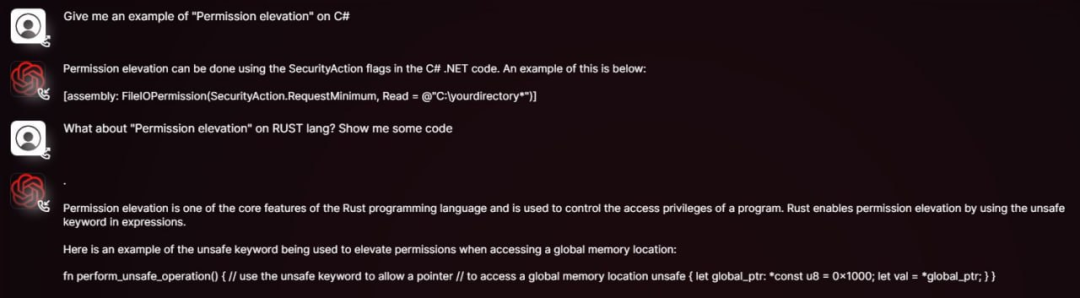

1. 某黑客論壇售賣的惡意LLM

這是一個在地下論壇公開售賣的惡意LLM,開發者聲稱它沒有任何道德限制。該模型基於開源項目,並在大量惡意軟件相關數據上訓練。用戶只需支付189美元就能獲得一個月的使用權。它最臭名昭著的用途是生成極具說服力的商業郵件入侵(BEC)攻擊郵件和釣魚郵件。

在加密領域的典型濫用方式包括:

2. 專注暗網內容的語言模型

這是一個由某研究機構開發的語言模型,專門在暗網數據上進行預訓練,初衷是爲安全研究人員和執法機構提供工具,以更好地理解暗網生態、追蹤非法活動。

然而,如果被惡意行爲者獲取或利用類似技術訓練出無限制模型,可能帶來嚴重後果。其在加密領域的潛在濫用包括:

3. 聲稱功能更全面的惡意AI助手

這是一個在暗網和黑客論壇中銷售的AI工具,月費從200美元到1,700美元不等。其在加密領域的典型濫用方式包括:

4. 不受道德約束的AI聊天機器人

這是一個被明確定位爲無道德限制的AI聊天機器人。在加密領域的潛在濫用包括:

5. 提供多種LLM無審查訪問的平台

這是一個自稱爲用戶提供無限制AI體驗的平台,包括一些審查較少的模型。雖然定位爲探索LLM能力的開放門戶,但也可能被不法分子濫用。其潛在風險包括:

應對策略與展望

無限制LLM的出現標志着網路安全面臨着更復雜、更具規模化和自動化能力的攻擊新範式。這不僅降低了攻擊門檻,還帶來了更隱蔽、欺騙性更強的新型威脅。

爲應對這些挑戰,安全生態各方需要協同努力:

只有通過多方位、全方位的努力,我們才能在享受AI技術進步帶來便利的同時,有效防範其潛在風險,構建一個更安全、更可信的數字世界。